Dostal jsem příležitost zúčastnit se dvou konferencí pro IT pracovníky na univerzitách. Jedna z nich EUNIS – Evropská Organizace pro Univerzitní Informační Systémy, která se letos zaměřila právě na knihovní systémy, a druhá ELAG – European Library Automation Group. Co zajímavého bylo na programu? Mají knihovní informatici stejné starosti jako univerzitní?

Hlavní témata EUNIS

Kontrola plagiátů se řeší na každé univerzitě. V našem českém prostředí se nejčastěji využívá služba theses.cz. Pro střední školy je pak k dispozici služba odevzdej.cz a pro vědecké práce služba repozitář.cz. Všechny tyto služby pak fungují jako základna dat pro kontrolu na plagiáty.

V rámci národního konsorcia CzechElib a NTK vznikají další podpůrné služby, které nám knihovníkům velice zjednoduší život. První je kolektivní ERMS (Electronic resources management system). Členské instituce by si zde měly mít možnost spravovat všechny své předplácené elektronické zdroje včetně těch, které nejsou nakupovány přes konsorcium. Následně také si nechat vygenerovat A-Z seznamy. Druhou službou je systém Získej, který by měl nahradit služby VPK a MVS. Je to serverová aplikace vyvíjená pod licencí open source GPL a v jazyce Python. Primární případ užití je integrace v existujících knihovních systémech skrze API, nicméně bude k dispozici také grafické rozhraní. Autentizace uživatelů bude probíhat přes eduID. Platby za zpřístupněné zdroje bude možné provést buď přes platební bránu v případě jednotlivců, tak i přes fakturu či předplacený kredit v případě institucí. Dokonce se dojednává i smlouva s Českou poštou pro doručování MVS pro uživatele v rámci systému zdarma.

Univerzitní informační systémy reflektují potřeby svých uživatelů, tedy většinou. Kolegové ze ZČU vyvíjející systém STAG předvedli několik inovací. Jednou z nich je propojení tvorby anotace předmětu s knihovním katalogem, kdy kantor může rovnou zadávat knihy z katalogu a pokud tam publikaci nenajde, zadá ji ručně. Benefitem pro knihovnu je okamžité odeslání takto ručně zadaného titulu do akvizičního oddělení knihovny. Obecně se mi velice líbí úzké propojení univerzitního systému, knihovního systému, repozitáře, systému identit a systému publikační činnosti. Nejde totiž jen o propojení na úrovni výměny metadat, ale i poskládání celkového workflow při jednotlivých úkonech zadávání prací, psaní anotací předmětů, registrace uživatele apod.

Hlavní témata ELAG

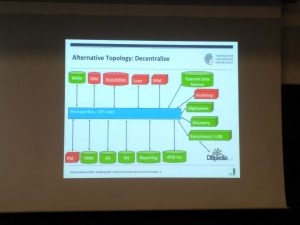

Klíčovým tématem letošního ELAGu bylo propojování a naopak oddělování dat. Keynote se ujal Ruben Verborgh. Opřel se do současné pozice agregátorů dat zejména v oblasti sociálních médií, ale i v oblasti publikování. Data u těchto agregátorů jsou centralizována a de facto je vlastní samotní provozovatelé. Ruben navrhuje opačnou decentralizovanou možnost. Lidé by publikovali statusy, „lajky“ atp. u sebe a např. Facebook by byl pouze agregátorem těchto dat od uživatelů. Zároveň zmínil důležitost popsání těchto dat nejpoužívanějšími metadatovými schématy a představil i skript, který aplikuje na svém webu, který každý den obohatí metadatový popis jeho dat do několika různých schémat – Dublin Core, DBPedia, FOAF, Schema.org. Ruben nezůstal jen u sociálních sítí, ale kopnul si také do agregátorů v oblasti publikování vědecké literatury – ResearchGate, Mendeley, Scopus, Academia. Jejich záznamy jsou totiž zpravidla neúplné, nepřesné a nespolehlivé. Navrhuje stejné řešení: zdrojem dat budou jednotlivci či instituce a tyto služby budou data pouze přebírat.

Dalším tématem byly samozřejmě Linked Data a obohacování záznamů v katalozích a repozitářích. Zaujala mě přednáška o tvorbě SKOS katalogu témat pro potřeby katalogizace Open Educational Resources (OER). Tradiční postup, kdy ručně hledáte zdroje, případně je harvestujete je poněkud krkolomný a mnoho webových katalogů skončilo právě kvůli tomu, že je neměl kdo udržovat. Zde byl navžen opačný postup za využití Linked Data Notifications. To znamená, že každý termín ve SKOS by byl jakýsi hub, ke kterému by se zdroje připojovaly samy zasláním zprávy na jeho linked data rozhraní.

Jan Pokorný z NTK představil jejich systém pro extrakci klíčových slov z obsahů publikací. V dnešní době elektronických knih by mohla tato velmi stará metoda znamenat značný přínos pro koncového uživatele, ale i katalogizátory. Obsah je nejdříve podroben zpracování za účelem vybrání pouze názvů kapitol a počtu stran, které zabírají. V tomto kroku je aplikováno strojové učení, protože obsahy jsou většinou součástí designu publikace a mohou tedy vypadat všelijak. Výsledkem procesu je pak seznam klíčových slov pro katalogizátora s jejich vahami na základě počtu stran, na kterých je v dané kapitole klíčové slovo zmíněno. Tento seznam je také namapován na související klíčová slova v Konspektu a MDT.

Příspěvkem na téma Open Access byl německý Open Access hub DeepGreen, který si klade za cíl agregovat metadata o open access publikacích u vydavatelů. DeepGreen je vyvíjen primárně pro německé konsorcium a má zacíl usnadnit přenos OA publikací od vydavatelů do institucionálních repozitářů. Slouží tedy jako prostředník mezi vydavateli a institucemi. Služba ve své první fázi pracovala se dvěma vydavateli a úspěšnost pokrytí OA publikací byla cca 95 %.

Dalším velkým tématem bylo budování knihovních systémů. Ty současné jako například Aleph totiž značně dosluhují a mnohdy už přesluhují. Ačkoliv jejich dodavatelé mají v rukávu „moderní“ knihovní systémy, je nutné se zamyslet nad tím, co od knihovního systému vlastně chceme. Chceme modulárnost? Linked data? Moderní API? Ukládání do cloudu? Na německé Technische Universität Darmstadt se právě nad těmito otázkami zamysleli, vyzkoušeli několik komerčně nabízených řešení a nakonec se rozhodli vyzkoušet Open Source. Konkrétně vyhradili jeden FTE na programování softwaru FOLIO s vizí, že v budoucnu kolem něj postaví svůj vlastní knihovní systém.